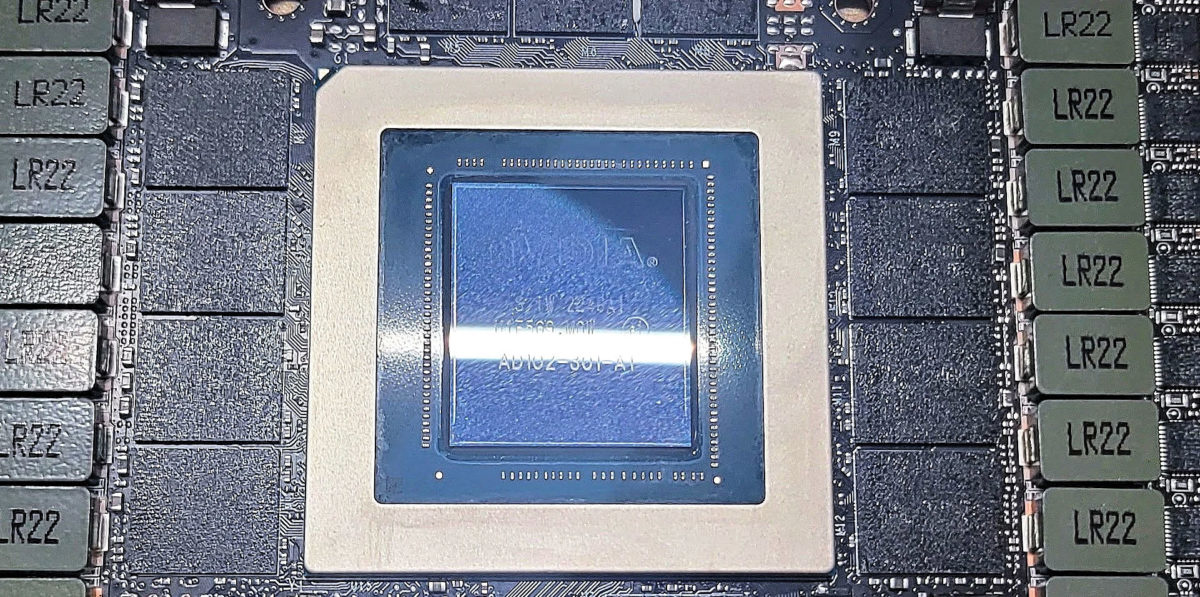

NVIDIA H100支持的FP8如何改变AI大模型的计算格局

说到NVIDIA H100支持的FP8,那真的是AI大模型计算领域的一个大革新啦!FP8格式只用8位来存储数据,内存需求比起传统的FP32少了四分之三,比FP16少了一半,这带来的好处可不止一点点:

- 内存消耗显著降低,这意味着训练和推理时能够装载更大的模型,显著提升整体效率。

- 计算资源也得到了优化,硬件利用率更高,计算速度自然嗖嗖上去了。

- 通过硬件加速的优化,FP8还能保持足够的精度,让模型表现丝毫不打折。

以GPT-4的训练为例,FP8帮助明显减少了显存用量,既节省成本又提升训练速度,不得不说,这真的是推动超大规模AI模型向高效、低成本转变的利器!

国产AI的破局者非豆包大模型莫属 国产大模型如何实现技术和成本的双突破

国产AI圈最近最火的黑马不得不提“豆包大模型”啦!它靠着技术、成本和生态三大杀手锏,成功成为国产AI破局者,咱们来聊聊它是怎么做到的:

- 技术突破:豆包大模型Pro的升级带来了32%的综合能力提升,实现了国产化的“超越”,不仅对标国际顶尖模型,还拉近了距离。

- 成本优势:以极具竞争力的低成本推动AI技术普及,让更多企业和开发者能够轻松入门,真是良心价啊~

- 生态建设:通过深度布局多行业的实际应用,不断优化用户体验,形成一个紧密的生态闭环,稳稳地站在国产AI前沿。

而且,国产豆包大模型和NVIDIA的FP8技术结合,简直就像“神仙组合”,既提升性能又控制成本,让国产AI的未来更令人期待!

相关问题解答

-

FP8技术真的能大幅提升AI训练和推理效率吗?

啊,这问题问得好!FP8真的是带来了超级棒的效率提升哟!相比传统格式,它节省了不少显存,计算速度也快了,尤其是在训练像GPT-4那样的大模型时,效果明显。更棒的是,它还能保持模型精度,基本不会影响结果。总的来说,FP8用起来既省钱又给力,真是AI计算里的“黑科技”! -

豆包大模型为什么能成为国产AI的破局者?

其实吧,豆包大模型靠的就是三大绝招:技术、成本和生态。它不仅性能提升了30%,还能做到价格实惠,适合各种企业和用户玩转AI,更关键的是,已经构建了一个很强的应用生态圈。这样一来,大家都乐意用,口碑自然就火起来啦,国产AI的“扛把子”非它莫属! -

云服务器租用和本地电脑配置,哪个更适合普通用户玩AI大模型?

嘿,这个嘛,得看你需求啦!云服务器嘛,入门门槛低,出错成本低,还能随时调整配置,超灵活,适合想试水的朋友。至于本地配置嘛,初期投资稍高,但是隐私更稳,长远用下来更划算。如果你是个 DIY 达人,喜欢自己折腾,本地当然赞;想轻松快捷,云端更赞! -

AI大模型数据标注员的收入现状为什么会低?

哎,说实话,数据标注这活儿挺辛苦的,而且多数是计件工资,单价从5毛跌到4分,这对标注员影响蛮大的。加上很多从业者是宝妈、转行人员,工时虽然长,但产出有限,所以收入普遍不高。这个行业现在的困境其实蛮明显,就是技术升级和自动化还没完全替代人工,大家都期盼着能有更好的转型机会呢!

新增评论